導(dǎo)讀:什么是robots.txt文件?robots文件,簡單來說,就是網(wǎng)站與搜索引擎之間的協(xié)議。網(wǎng)站通過robots文件告訴搜索引擎蜘蛛,網(wǎng)站內(nèi)部哪些內(nèi)容是允許抓取,哪些內(nèi)容是不允許抓取。蜘蛛抓取網(wǎng)站內(nèi)容之前先會(huì)抓取網(wǎng)站里的這個(gè)文件,依據(jù)此文件來判斷哪些內(nèi)容是需要抓取,哪些內(nèi)容是不需要抓取。

看了很多企業(yè)網(wǎng)站的robots文件,要么沒有寫,要么寫的很亂。如果沒有寫,蜘蛛就會(huì)抓取網(wǎng)站所有的文件,不利于優(yōu)化,更不利于保護(hù)需要保護(hù)的數(shù)據(jù),比如用戶信息;寫的亂,不允許許抓取的內(nèi)容,卻被抓取,允許抓取的內(nèi)容,反而沒被抓取,嚴(yán)重影響網(wǎng)站內(nèi)容收錄,以及對(duì)網(wǎng)站重要內(nèi)容的保護(hù),下面深度網(wǎng)小編為大家詳細(xì)分析robots文件的應(yīng)用以及存在的誤區(qū)。

一、怎么查詢r(jià)obots.txt文件?

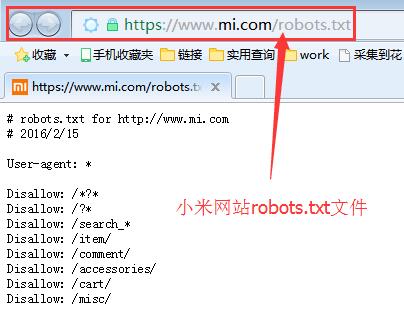

robots.txt文件都是放在網(wǎng)站根目錄下面,我們只要在域名后面輸入robots.txt,然后按確認(rèn)鍵,就會(huì)彈出robots文件內(nèi)容,如圖所示:

二、robots.txt文件使用誤區(qū)。

1、網(wǎng)站所有文件都可以被抓取,不去設(shè)置robots.txt文件,默認(rèn)讓搜索引擎抓取整個(gè)的網(wǎng)站文件,這樣不更利于優(yōu)化。現(xiàn)實(shí)不是這樣的,蜘蛛每次來抓取網(wǎng)站先會(huì)抓取robots.txt文件,如果文件不存在,蜘蛛就會(huì)認(rèn)為是死鏈,就在網(wǎng)站日志記錄為死鏈,嚴(yán)重影響蜘蛛友好度。

2、在robots.txt文件中設(shè)置所有的文件都允許搜索引擎蜘蛛抓取,讓搜索引擎能夠收錄更多頁面。其實(shí)搜索引擎蜘蛛對(duì)于網(wǎng)站程序腳本、css樣式、js文件等,很難被搜索引擎收錄,就算收錄了,也只會(huì)浪費(fèi)服務(wù)器資源,這種對(duì)網(wǎng)站保護(hù)性很差,對(duì)蜘蛛體驗(yàn)不友好。

3、在robots.txt文件中設(shè)置不抓取整個(gè)網(wǎng)站內(nèi)容,不讓抓取意味著整個(gè)網(wǎng)站都不會(huì)被搜索引擎收錄,不被收錄的話,關(guān)鍵詞難以獲得排名,在好的營銷內(nèi)容,也難以被用戶看到。

三、正確對(duì)待robots.txt使用技巧。

我們網(wǎng)站都是由許多文件組成,比如我們常見的有后臺(tái)管理文件、程序腳本、附件、數(shù)據(jù)庫文件、編碼文件、樣式表文件、模板文件、導(dǎo)航圖片和背景圖片等等,有些文件是不需要搜索引擎去收錄的,直接屏蔽蜘蛛抓取,讓蜘蛛更好的爬行需要被抓取的內(nèi)容,減輕蜘蛛負(fù)擔(dān),提高抓取效率,切記網(wǎng)站里不要空著,不去設(shè)置robots.txt文件。

總結(jié),robots.txt文件對(duì)于網(wǎng)站優(yōu)化有很大的幫助,提高蜘蛛抓取效率,還能保護(hù)網(wǎng)站內(nèi)部需要保護(hù)的信息。在網(wǎng)站上線前,一定要檢查robots.txt文件,如果沒有及時(shí)添加,如果規(guī)則寫錯(cuò)了,及時(shí)調(diào)整過來,以免影響網(wǎng)站的收錄。以上就是深度網(wǎng)小編分享的有關(guān)robots.txt文件的作用。